埼玉県を中心に200店舗を展開(2025年12月末時点)する大手食品スーパーマーケットのヤオコーでは、店舗アプリやECネットスーパー、AIを活用した業務改革を通じて、顧客体験と店舗運営のさらなる向上を目指したDX戦略を推進しています。

AIによる自動発注をはじめとした業務支援の取り組みが進む中で、その前提となる「データ基盤」のあり方を見直し、Snowflakeとdbtを活用したモダナイゼーションを実現しました。

本記事では、Snowflakeを中心としたデータ基盤の刷新を通じて、AI活用を見据えた土台づくりにどのように取り組んできたのか、その背景や意思決定の過程をひもときます。

株式会社ヤオコーで執行役員CDO 兼 デジタル統括部長の小笠原氏、デジタル統括部 プロダクト開発担当マネージャ・テックリードの吉岡氏に、弊社 執行役員 兼 ちゅらデータでCTO菱沼が話を伺いました。

本記事は、Snowflake合同会社主催のオンラインイベント「INDUSTRY DAYS JAPAN 2025」の当社セッション(2025年11月26日配信)の内容をもとに構成しています。

スピーカー紹介

CXと生産性の向上を両立する、ヤオコーのDX

小笠原氏:当社ではCX向上に向けた取り組みとして、ヤオコーアプリに搭載している電子マネー「ヤオコーペイ」の導入やECネットスーパーの展開、コールセンターのクラウド化・生成AI活用など、さまざまな施策を進めています。

店舗業務の生産性向上において特に効果を発揮しているのが、AIによる自動発注です。ヤオコーでは1店舗あたり約15,000SKU(Stock Keeping Unit:在庫管理における最小単位)の商品を扱っていますが、そのうち約11,000SKUの商品はAIによる需要予測をもとに自動発注しています。加えて、スマートフォンやタブレットを活用した店舗業務支援アプリやデジタルプライス、フルセルフレジなどを通じて、店舗全体の業務効率化を進めています。

IT基盤についてはAWSを中心としたクラウドネイティブな環境を整備し、監視・運用の自動化にも注力してきました。こうした取り組みの延長として、データ活用の領域ではSnowflakeやStreamlitを活用し、将来のAI活用を見据えたデータ基盤の刷新に取り組んでいます。

内製化と運用負荷軽減を見据えた、データ基盤刷新の背景

菱沼:ヤオコー様でDXを進められていく中で、まずデータ基盤のマイグレーションに着手されたわけですが、どんな課題があり、どのような経緯で、Snowflakeを選択されたのでしょうか。

吉岡氏:課題は大きく分けて二つありました。一つ目は、当時ベンダーとしてサポートいただいていたパートナー企業主導で開発を進めていたため、インターフェース用のファイルを一つ追加するだけでも、ベンダーを経由しないと実装できないという運用上の制約があった点です。その結果、コストが増大するだけでなく、開発スピードも担保できない状況に陥っていました。こうした背景から、今後は内製化を進めていく必要があると考え、いわゆるモダンアーキテクチャへの移行を検討し始めました。

二つ目は、AWSのS3上にインフラやミドルウェアを含めたすべてを構築・運用していく中で、意図しないトラブルがたびたび発生していたことです。このまま同じ構成で継続していくことは運用・保守の両面において、複雑さが増していく懸念がありました。

菱沼:私たちのような開発支援を担う立場から見ても、独自のフレームワークや過度なカスタマイズが多い構成では、障害発生時の原因調査に想定以上の時間を要してしまうケースがあります。特に、ヤオコー様のように内製化を志向されている企業様にとっては、こうした状況が運営上の大きなリスクになり得ますよね。

そうした背景の中で、Snowflakeを選択されたきっかけや理由について、あらためて教えていただけますか。

吉岡氏:まず、Snowflakeはストレージとコンピュートリソースが完全に分離されたアーキテクチャである点が大きな利点だと考えました。これまで外部環境で行っていたデータの変換・加工処理についても、Snowflakeのインフラ内で一貫して実装・運用できる点に魅力を感じます。

また、Snowflakeを採用するにあたっては、dbtの思想やワークフローとの親和性が非常に高い点も重要な評価ポイントでした。両者を組み合わせた形で新しいデータ基盤を構築すべきだと考え、その実現にあたって両ソリューションの開発に精通したパートナー企業を探していたところ、DATUM STUDIOさんにお声がけいただいた、という経緯になります。

菱沼:吉岡様がSNSでパートナー企業を探されている投稿を拝見し、社内で話題になりました。当時は、Snowflakeをはじめとするモダンデータスタックに深く精通した企業はまだ限られており、「ここは自分たちが手を挙げるべきだ」と、ヤオコー様にご連絡を差し上げたことが、プロジェクトのきっかけでしたね。

吉岡氏:アーキテクチャについては、複数のソリューションを比較・検討したうえで、最終的に現在の構成に決定しました。

データ連携に関しては、弊社は扱うデータ量が非常に多いため採用技術によってはコスト面での負荷が大きくなることが課題でした。そのためコストパフォーマンスや実装のしやすさを軸に検討しました。その結果、AWS S3上に既存データがあったこともありSnowpipeとの親和性が高いと判断し、現在、データ連携の中核としてSnowpipeを採用しています。

菱沼:コストの最適化や内製化を見据えた観点では、Snowpipeは非常に優れた選択肢だと思います。

一方で今回の基盤構築では、特にデータ変換領域のアーキテクチャが大きく刷新されました。以前は、JP1とC#を用いた独自のフレームワークでデータ変換を行っていたと理解していますが、Snowflakeとdbtを採用し、モダナイゼーションを進められた理由や背景についても教えてください。

吉岡氏:dbtはCI/CD(※1)やDevOps(※2)といった開発スタイルと非常に親和性が高く、内製化を見据える中でCI/CDは不可欠だと考え、最終的にSnowflakeとdbtという組み合わせを選択しました。

菱沼:昨今の内製化を前提とした開発においては、自動化を見据えた技術選定が欠かせないと考えています。そうした観点から私たち自身も多くのクライアントに対して、Snowflakeとdbtの組み合わせをはじめとした、開発生産性の高いアーキテクチャを提案する機会が増えています。

高速化と現場定着を実現した分析基盤とその成果

菱沼:次に、データの可視化についてもお伺いしたいのですが、MartSolutionから始まり段階的な見直しを経て、現在はStreamlitとDomoの組み合わせで可視化されていますが、当時の課題や導入の背景について教えてください。

吉岡氏:BIツールについては、これまでさまざまなソリューションを試してきました。先述のとおり、弊社は非常に膨大なデータを保有しているため、機能要件としてまず重視したのはスピードです。

キャッシュ前提で対応できそうなケースもありましたが、データ量を考えると全てをキャッシュに載せることは現実的ではありませんでした。

そこで、柔軟に分析できるStreamlitに加え、分析の自由度や表現力を補完するため、よりBIツール寄りのソリューションも必要だと考えました。最終的にはそれぞれの強みを活かす形で、StreamlitとDomoを組み合わせたハイブリッドな構成を採用しています。

菱沼:スピード面において、Streamlitの評価が高い印象があります。

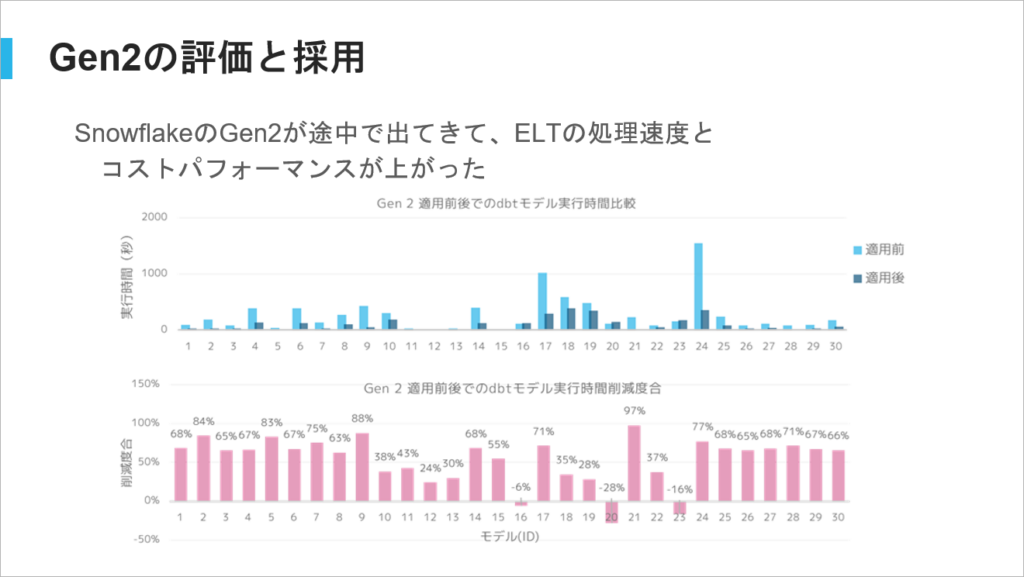

一方で、数ヶ月前にGA(General Availability:一般提供開始)され、分析性能を高速化した第2世代のSnowflake(以下、Gen2)については、実環境での検証を経て導入を決定しました。評価や率直な感想を教えてください。

吉岡氏:上図のとおり、パフォーマンスは非常に優れていると感じています。Snowflakeでは、コンピュートリソースの使用量がそのままコストに直結するため、実行時間が短くなればコストも下げられるという、わかりやすい構造です。処理速度とコストの両面で効果を実感できており、まさに嬉しい悲鳴ですね。

菱沼:Gen2が発表された時、レガシーなDWH製品からSnowflakeへマイグレーションした際と同じことが起きるのではないか、と感じました。つまり、処理が速くなり、なおかつコストも下がる。そうした変化が、従来のGen1からGen2への移行においても同様に起こるだろうと考えていました。

実際に触ってみると互換性も非常に高く、デメリットはほとんど感じませんでした。部分的には従来構成を下回るケースもありますが、多くのケースで良い結果が得られたことは素直にうれしかったです。BI領域についてはいかがでしょうか。

吉岡氏:BIについては、SPCS(Snowpark Container Services)上にStreamlitを配置して実装したものと、Domoを組み合わせたアーキテクチャを採用しました。標準的なStreamlitの画面とは思えないほどカスタマイズしているため、その過程では正直かなり苦労しました。

既存システムからのマイグレーションは、組織とって大きな障壁になりがちなので、現場が違和感なく使えるよう、UIや操作性には特にこだわり、試行錯誤を重ねました。

菱沼:SPCSを活用し、Snowflakeの中で完結した形で作りきれた点は、非常に面白く、かつ上手くいったポイントでしたね。

さて、モダナイゼーションという観点では約2年間かけて取り組んできたプロジェクトでしたが、今振り返ってみていかがですか。

吉岡氏:Snowflakeを採用したことで、特にマイクロパーティション(※3)の恩恵は非常に大きいと実感しています。

たとえばヤオコーでは、各店長が開店前や休憩時間、あるいは来店客が最も多い時間帯など、特定のタイミングにデータ分析へのアクセスが集中することがよくあります。そうした状況でもパフォーマンスを気にすることなく、必要な分析を行える点は、本当に素晴らしいと感じています。

また、インフラレイヤーにおいては、本来の業務に集中するために必要だったメンテナンス作業の手離れが良くなり、運用工数を削減できる見込みです。

さらに、従来はC#で独自実装していた部分をPythonやSQL、dbt、Snowflakeといったコミニュティが成熟したエコシステムを持つ技術で構築できた点も大きなポイントです。

カスタマイズの自由度も高まり、レスポンシブ対応によってiPadをはじめとしたさまざまなデバイスでの活用も今後さらに広がっていくと考えています。

菱沼:あと少しで現場の皆さんに展開できるフェーズまで来ましたが、次のステップに向けた課題はありますか。

吉岡氏:これまでDATUM STUDIOさんにサポートいただいてきましたが、今後はStreamlitを含め、当社メンバー主体で運用・追加開発を進めていくフェーズに入っていくと考えています。そのためにも引き続きキャッチアップと改善を重ねていく必要があります。

また、開発生産性の観点では、より効率的に検証・開発できる環境づくりも進めていきたいと考えています。

そのうえで今後は、Snowflake IntelligenceやCortex AIといったSnowflake上のAI機能に加え、一般的な開発におけるAI活用も含め、AIを前提としたデータ分析の環境を整えていきたいです。社員がAIと対話しながら仮説検証を進め、「攻めのデータ分析」ができる土台を作っていくことが、次の大きな目標ですね。

菱沼:AI戦略の実現には、その土台となるデータ戦略が欠かせないことを私たち自身も強く実感しています。

実際には今回お話ししたような地道な取り組みの積み重ねこそが、将来の価値につながると考えています。

※1 Continuous Integration(継続的インテグレーション)/ Continuous Delivery(継続的デリバリー)」の略称。特定の技術を指すものではなく、ソフトウェアの変更を常にテストし、自動で本番環境に適用できる状態にしておく開発手法

※2 システム開発手法の1つで、開発チームと運用チームが協力して開発を進めること。迅速な開発プロセスを実現する組織体制の構築を目的とする

※3 Snowflakeがデータを自動的に細かく分割し、必要な部分だけを高速に読み込めるようにする仕組み